فایل Robots.txt چیست؟ چگونگی ساخت و نکات مهم robots.txt

robots.txt چیست؟

فایلی است که به کراولر موتور جستجو می گوید صفحات یا بخش های خاصی از یک سایت را کراول نکنند. بیشتر موتورهای جستجوی بزرگ (از جمله گوگل، بینگ و یاهو) دستورات Robots.txt را تشخیص داده و طبق آن عمل می کنند.

این فایل اولین بار توسط موتورهای جستجو در دهه 1990 معرفی شد و از آن زمان به یکی از ابزارهای ضروری برای مدیریت دسترسی به محتواهای وبسایت تبدیل شده است.

چرا Robots.txt مهم است؟

اکثر سایت ها به فایل robots.txt نیازی ندارند به این دلیل که گوگل معمولاً می تواند تمام صفحات مهم سایت شما را پیدا و ایندکس کند و آنها به طور خودکار صفحاتی را که مهم نیستند یا نسخه های تکراری صفحات را ایندکس نخواهند کرد با این وجود، 3 دلیل مهم وجود دارد که باید از robots.txt استفاده کنید.

بلاک کردن صفحات غیر عمومی: بعضی اوقات صفحاتی در سایت خود دارید که نمی خواهید ایندکس شوند. به عنوان مثال، صفحه لاگین سایت باید در سایت شما وجود داشته باشد ولی نیاز نیست در ایندکس گوگل قرار بگیرد. این موردی است که شما می توانید از robots.txt برای بلاک کردن این صفحات برای کراولر و ربات های موتور جستجو استفاده کنید.

crawl budget را کنترل کنید: اگر برای ایندکس صفحات خود مشکل دارید و گاهی در سرچ کنسول خود متوجه می شوید که برخی صفحات ایندکس نشده اند پس این نشان دهنده مشکل بودجه خزیدن crawl budget است. با بلاک کردن صفحات غیر مهم برای ربات گوگل در robots.txt، می تواند crawl budget را در صفحاتی که واقعاً مهم هستند، هزینه کنید.

جلوگیری از ایندکس منابع: استفاده از تگ های متا می تواند به اندازه Robots.txt برای جلوگیری از ایندکس شدن صفحات مفید باشد. با این حال، تگ های متا برای منابع چندرسانه ای مانند PDF و تصاویر به خوبی کار نمی کنند. در اینجا robots.txt می تواند جایگزین آن شود.

به طور کلی Robots.txt به کراولرهای موتور جستجو می گوید که صفحات خاصی از سایت شما را کراول نکنند.

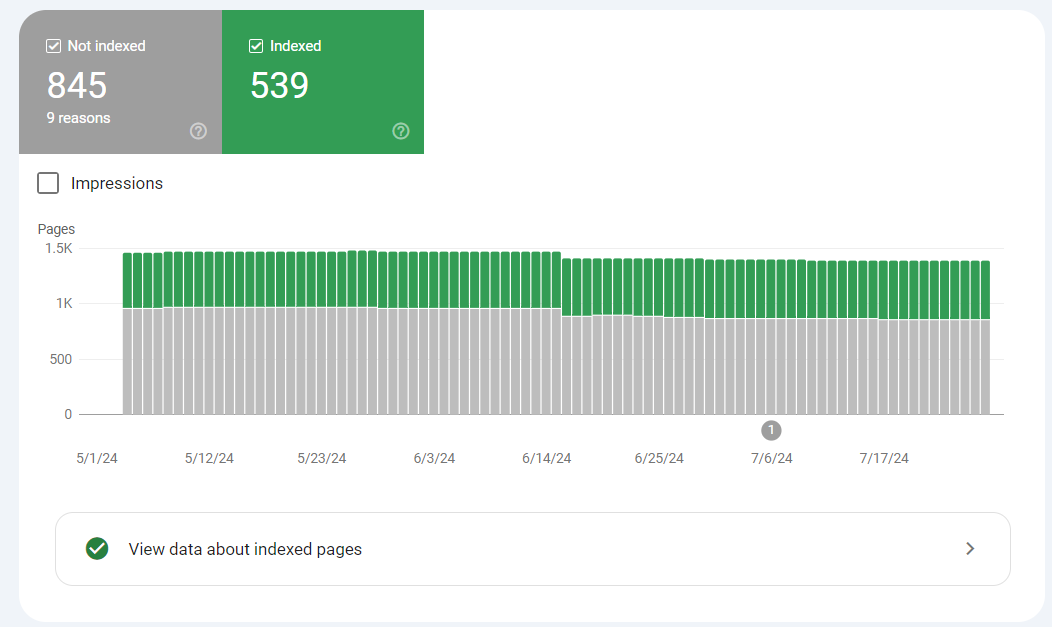

در سرچ کنسول می توانید ببینید که چه تعداد از صفحات شما ایندکس شده است.

اگر این شماره با تعداد صفحاتی که می خواهید ایندکس شوند یکی بود، نیازی نیست به ROBOTS.TX نخواهید داشت.

اما اگر این تعداد بیش از حد انتظار شما باشد (و متوجه صفحاتی ایندکس شده ای شوید که نباید ایندکس شوند)، وقت آن است که یک فایل robots.txt برای سایت خود ایجاد کنید.

نحوه ساخت و تنظیم فایل robots.txt برای سایت

یک فایل با نام Robots.txt ایجاد کنید

اولین قدم شما ایجاد فایل robots.txt است که برای ایجاد آن می توانید از notepad ویندوز استفاده کنید و مهم نیست که در نهایت فایل robots.txt خود را چگونه می سازید، قالب دقیقاً یکسان است:

User-agent: X

Disallow: Y

User-agent رباتی است که با آن صحبت می کنید و هر چیزی که پس از "Disallow" می آید صفحات یا بخشهایی است که می خواهید بلاک کنید.

برای مثال:

User-agent: googlebot

Disallow: /images

این قانون به Googlebot می گوید که پوشه تصویر سایت شما را ایندکس نکند.

همچنین می توانید از ستاره (*) برای بلاک کردن همه ربات ها استفاده می شود.

برای مثال:

User-agent: *

Disallow: /images

"*" به همه کراولرها می گوید که پوشه تصاویر شما را کراول نکنند.

این فقط یکی از روش های استفاده از فایل robots.txt است. این راهنمای مفید از Google دارای اطلاعات بیشتری در مورد قوانین مختلفی است که می توانید برای جلوگیری از رباتها در صفحات مختلف سایت خود استفاده کنید.

پیدا کردن فایل Robots.txt را آسان کنید

زمانی که فایل robots.txt خود را ساختید، نوبت به آپلود کردن آن می رسد.

شما می توانید فایل robots.txt خود را در هر main directory سایت خود قرار دهید.

اما ما توصیه می کنیم آن را به این صورت قرار دهید:

https://example.com/robots.txt

(توجه داشته باشید که فایل robots.txt به حروف کوچک و بزرگ حساس است. بنابراین مطمئن شوید که از "r" کوچک در نام پرونده استفاده کنید)

تست robots.txt

واقعاً مهم است که فایل robots.txt شما به درستی تنظیم شود. یک اشتباه ممکن است کل سایت شما را از ایندکسی خارج کند.

خوشبختانه نیازی نیست به صورت دستی همه خودتان به بررسی فایل ROBOTS.TXT بپردازید. Robots Testing Tool ربات عالی برای این کار است:

این هرگونه error و warning را نشان می دهد:

همانطور که می بینید، ما کراولر ها را از کراول کردن صفحه WP admin منع می کنیم.

Robots.txt یا متا تگ ها

چرا وقتی می توانید از برچسب متا "noindex" برای بلاک کردن ربات ها استفاده کنید، از robots.txt استفاده می کنید؟

همانطور که قبلاً اشاره کردیم، برچسب noindex روی منابع چندرسانه ای مانند فیلم ها و PDF خیلی خوب عمل نمی کند.

همچنین، اگر هزاران صفحه دارید که می خواهید آنها را بلاک کنید، مسدود کردن کل بخش آن سایت با robots.txt راحت تر از افزودن دستی برچسب noindex به هر صفحه است.

همچنین مواردی وجود دارد که شما نمی خواهید هیچ crawl budget را برای فرود گوگل در صفحات دارای برچسب noindex هدر دهید.

علاوه بر این موارد من توصیه می کنم به جای robots.txt از تگ متا استفاده کنید. اجرای آنها آسان تر است. و احتمال وقوع یک فاجعه کمتر است (مانند مسدود کردن کل سایت خود)

پرسش های متداول

1. فایل Robots.txt چیست؟

فایل robots.txt یک فایل متنی است که در ریشه وبسایت قرار میگیرد و به موتورهای جستجو میگوید که کدام صفحات را باید و نباید ایندکس کنند

2.آیا همه سایت ها به فایل Robots.txt نیاز دارند؟

خیر، اما بهتر است تمامی وبسایتها از این فایل استفاده کنند تا به موتورهای جستجو بگویند که کدام صفحات باید ایندکس شوند

3. آیا میتوان فایل Robots.txt را نادیده گرفت؟

بله، برخی موتورهای جستجو ممکن است این فایل را نادیده بگیرند، اما بیشتر موتورهای جستجو از آن پیروی میکنند

4. آیا فایل Robots.txt میتواند به سئو آسیب برساند؟

اگر به درستی استفاده نشود، ممکن است تاثیر منفی بر سئو داشته باشد

5. چگونه میتوان فایل Robots.txt را بهینه کرد؟

با استفاده از دستورات دقیق و تست فایل میتوانید آن را بهینه کنید

نتیجهگیری

فایل robots.txt یکی از ابزارهای مهم برای مدیریت ایندکس شدن صفحات وبسایت توسط موتورهای جستجو است. با استفاده درست از این فایل میتوانید اطمینان حاصل کنید که صفحات مهم وبسایت شما به درستی ایندکس میشوند و تجربه کاربری بهتری فراهم کنید